Au cœur d’une centrale nucléaire, chaque degré compte. Une variation thermique imperceptible peut déclencher une cascade de réactions physiques mettant en jeu la stabilité du réacteur. Les capteurs de température ne sont pas de simples instruments de mesure, mais les gardiens invisibles d’un équilibre critique où la moindre dérive peut basculer d’un fonctionnement optimal vers une situation préoccupante.

Cette criticité invisible des mesures thermiques impose des stratégies de fiabilisation sans équivalent dans l’industrie. Contrairement aux idées reçues, la sûreté nucléaire ne repose pas sur la perfection d’un capteur unique, mais sur une architecture complexe pensée pour anticiper la défaillance. De la redondance intelligente aux algorithmes de détection prédictive, chaque composant du système de mesure participe à garantir l’intégrité de l’installation, comme le détaillent les principes exposés sur correge.fr concernant le fonctionnement d’une centrale nucléaire.

Cet article explore les dimensions stratégiques rarement verbalisées de la mesure thermique nucléaire. Au-delà des aspects techniques élémentaires, nous analysons les cascades de conséquences thermiques, les dilemmes de conception entre précision et réactivité, et les évolutions technologiques qui transforment ce domaine critique. Une approche qui révèle comment la fiabilité d’un système ne se construit pas sur l’excellence individuelle, mais sur une pensée systémique de la défaillance.

La mesure thermique nucléaire en 5 points clés

- Les capteurs de température surveillent les cascades thermiques susceptibles de propager des effets critiques à travers l’ensemble des circuits du réacteur

- L’architecture de redondance diversifiée (thermocouple, RTD, fibre optique) garantit la continuité de mesure même en cas de défaillance multiple

- Le choix technologique arbitre entre précision absolue et temps de réponse selon les zones critiques et les phases opérationnelles

- Les systèmes modernes analysent les tendances et corrélations pour détecter les anomalies faibles avant qu’elles ne deviennent critiques

- Les innovations technologiques (fibres optiques, IA prédictive, capteurs diamant) transforment la surveillance thermique pour les réacteurs de nouvelle génération

Les cascades thermiques : quand un degré déclenche une réaction en chaîne

Dans le cœur d’un réacteur à eau pressurisée, la température nominale avoisine 323°C. Cette valeur n’est pas un simple paramètre opérationnel, mais le point d’équilibre d’un système physique où chaque variation thermique provoque des effets en cascade à travers l’ensemble de l’installation. La propagation thermique du cœur vers le circuit primaire obéit à des mécanismes de transfert complexes où les points critiques se multiplient.

L’effet domino commence au niveau microscopique. Une variation de 1°C peut modifier la réactivité du cœur de 30 pcm (pour cent mille), une unité qui mesure l’écart à la criticité. Cette modification de réactivité influence directement la puissance neutronique, qui elle-même génère plus ou moins de chaleur. Le système entre alors dans une boucle de rétroaction où la température initiale et la réactivité s’influencent mutuellement.

Une augmentation de température accroît l’agitation thermique des noyaux présents dans le cœur. Plus cette agitation est importante, plus le sont aussi les pertes de neutrons qui se produisent lors du ralentissement

– Experts en physique des réacteurs, La Radioactivité.com

Cette interaction physique non linéaire se propage ensuite au circuit primaire. Une hausse de température de 10°C dans le cœur entraîne une augmentation de pression de l’ordre de 2 bars dans le circuit primaire en moins de 30 secondes. Cette surpression modifie à son tour les conditions de transfert thermique au niveau des générateurs de vapeur, où la température chute à environ 280°C. Le rendement thermique global peut ainsi varier de 0,5% pour une dérive thermique apparemment mineure.

La chronologie d’une dérive thermique non détectée illustre la criticité de la surveillance continue. Lors des premières secondes, la variation reste confinée au cœur et se manifeste par une modification de la distribution spatiale de puissance. Entre 30 secondes et 2 minutes, les effets se propagent au circuit primaire avec des variations de pression et de débit. Au-delà de 3 minutes, le circuit secondaire commence à être affecté, compromettant l’efficacité de la production électrique. Si aucune action corrective n’intervient, le système peut basculer vers un état où les marges de sûreté se réduisent dangereusement.

| Zone du réacteur | Température nominale | Effet d’une hausse de 10°C | Temps de propagation |

|---|---|---|---|

| Cœur du réacteur | 323°C | Baisse de réactivité (-300 pcm) | Immédiat |

| Circuit primaire | 320°C | Augmentation pression (+2 bars) | 30 secondes |

| Générateur vapeur | 280°C | Modification rendement (-0.5%) | 2-3 minutes |

Les seuils de température critiques définissent les zones où le système bascule d’un état stable vers un état préoccupant. Au-delà de 340°C dans le cœur, les coefficients de réactivité deviennent fortement négatifs, signalant une instabilité potentielle. À 350°C, les marges de sûreté vis-à-vis de l’ébullition locale commencent à se réduire. Ces seuils justifient la précision extrême requise pour la mesure thermique, où une incertitude de quelques degrés peut masquer une situation dégradée.

L’architecture de redondance : penser la mesure comme un système de sûreté

Face aux cascades thermiques que nous venons d’explorer, une défaillance instrumentale pourrait rendre invisible une dérive critique. C’est pourquoi l’architecture de mesure ne repose jamais sur un capteur unique, mais sur une philosophie de conception où la redondance n’est pas une simple duplication, mais une stratégie pensée pour anticiper les modes de défaillance. Cette approche transforme la mesure de température en système de sûreté à part entière.

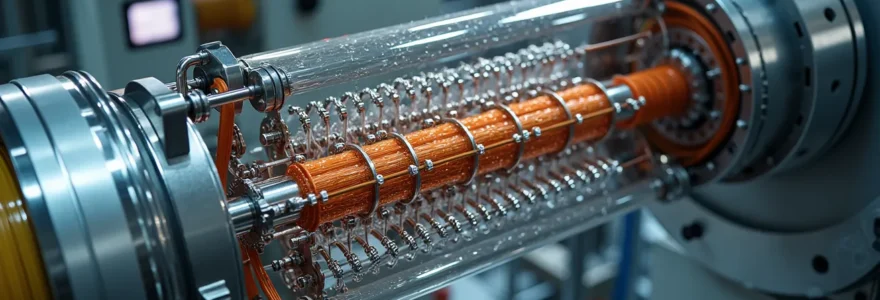

Le principe de diversification technologique constitue le premier pilier de cette architecture. Plutôt que de multiplier des capteurs identiques, les ingénieurs nucléaires combinent délibérément des technologies différentes : thermocouples de type K pour leur rapidité, RTD platine pour leur précision, et fibres optiques pour leur immunité aux interférences électromagnétiques. Cette diversité évite les défaillances de mode commun, où un même phénomène physique (rayonnement, vieillissement, dérive) affecterait simultanément tous les capteurs.

Défaillance capteur Cattenom 2024 : quand la redondance sauve la surveillance

Un capteur de pression défaillant depuis mars 2024 sur le réacteur 3 de Cattenom n’a été détecté qu’en juillet, illustrant l’importance de la redondance. Malgré cette défaillance prolongée, les autres capteurs redondants ont maintenu la surveillance du système, démontrant que l’architecture de sûreté fonctionne même face à une panne non diagnostiquée pendant plusieurs mois. Cet incident a conduit à renforcer les procédures de comparaison croisée entre voies de mesure.

La logique de vote 2/3 ou 2/4 dans les systèmes de protection illustre comment les signaux contradictoires sont arbitrés. Lorsque trois capteurs mesurent la même grandeur, le système ne déclenche une action de sûreté que si au moins deux capteurs franchissent simultanément le seuil d’alarme. Cette logique élimine les fausses alarmes dues à une défaillance isolée tout en garantissant qu’une anomalie réelle sera détectée même si un capteur est hors service. Dans une configuration 2/4, quatre capteurs permettent de tolérer jusqu’à deux défaillances simultanées sans perte de la fonction de protection.

| Technologie | Temps de réponse | Précision | Plage température |

|---|---|---|---|

| Thermocouple Type K | 0.5-2 sec | ±1.5°C | -200 à 1350°C |

| RTD Platine (Pt100) | 3-10 sec | ±0.1°C | -200 à 850°C |

| Fibre optique Bragg | 10-50 ms | ±0.2°C | -270 à 800°C |

Le positionnement spatial stratégique complète cette architecture. Les capteurs ne sont pas répartis aléatoirement, mais selon une distribution géométrique calculée pour capturer les gradients thermiques. Dans le cœur, plusieurs thermocouples sont disposés à différentes hauteurs et positions radiales pour détecter les déséquilibres de puissance. Dans le circuit primaire, la mesure différentielle entre la branche chaude (sortie du cœur) et la branche froide (entrée du cœur) permet de calculer la puissance thermique extraite avec une précision de 2%.

Principes de diversification technologique

- Installer au minimum 3 technologies différentes par zone critique (thermocouple, RTD, fibre optique)

- Séparer physiquement les chaînes de mesure pour éviter les modes communs de défaillance

- Implémenter une logique de vote 2/3 pour valider les mesures critiques

- Prévoir des capteurs de secours isolés électriquement du système principal

La ségrégation des chaînes de mesure assure l’indépendance électrique et physique nécessaire pour garantir la disponibilité. Les câbles de différentes voies de mesure empruntent des chemins séparés dans le bâtiment réacteur, alimentés par des sources électriques indépendantes. En cas d’incendie ou d’inondation localisée, cette séparation garantit qu’au moins une voie de mesure restera opérationnelle. Les résultats parlent d’eux-mêmes : 99.95% de disponibilité avec triple redondance diversifiée sur le parc nucléaire français en 2024.

Précision absolue contre temps de réponse : le dilemme de conception critique

L’architecture de redondance que nous venons d’examiner révèle une tension fondamentale : tous les capteurs ne sont pas égaux face aux impératifs contradictoires de la sûreté nucléaire. Cette dualité entre précision extrême et réactivité instantanée structure les choix technologiques à chaque étape de la conception. Les ingénieurs nucléaires doivent arbitrer entre l’exactitude de la mesure et la vitesse de détection selon les zones et les phases opérationnelles.

Les constantes de temps thermiques expliquent pourquoi un capteur précis peut devenir dangereux dans certaines situations transitoires. Un RTD platine, avec sa précision exceptionnelle de ±0.1°C, possède une masse thermique relativement importante qui nécessite 5 à 10 secondes pour atteindre l’équilibre thermique. Lors d’un transitoire rapide comme une rupture de tuyauterie, cette inertie peut retarder la détection de plusieurs secondes critiques. À l’inverse, un thermocouple de type K, moins précis (±1.5°C), réagit en moins de 2 secondes grâce à sa jonction miniature et sa faible masse.

Dans les réacteurs à eau pressurisée, la température du circuit primaire atteint environ 323°C. Cette chaleur est transmise au circuit secondaire sous forme de vapeur à 280-300°C seulement

– Nuclear Monitor, Analyse du rendement thermique des réacteurs

Le zonage fonctionnel résout ce dilemme en adaptant la technologie à l’objectif. Dans le cœur du réacteur, où les transitoires peuvent être brutaux, la priorité absolue est donnée à la réactivité. Les thermocouples dominent car ils détectent instantanément toute variation anormale, même au prix d’une incertitude de mesure plus élevée. Dans le circuit secondaire, où les évolutions sont plus lentes et où l’optimisation du rendement thermique devient prioritaire, les RTD platine fournissent la précision nécessaire au calcul exact de la puissance produite.

Les stratégies hybrides permettent d’exploiter simultanément plusieurs technologies pour compenser leurs limites respectives. Une approche courante consiste à coupler un thermocouple rapide avec un RTD précis dans la même zone. Le thermocouple assure la fonction de sûreté en déclenchant les alarmes rapides, tandis que le RTD fournit la mesure de référence pour le contrôle-commande et l’optimisation du procédé. Les deux signaux sont comparés en permanence pour détecter une éventuelle dérive instrumentale.

| Zone d’application | Priorité | Technologie privilégiée | Justification |

|---|---|---|---|

| Cœur du réacteur | Réactivité | Thermocouples | Détection rapide des transitoires |

| Circuit secondaire | Précision | RTD Platine | Optimisation rendement |

| Zones de sécurité | Hybride | Combinaison multiple | Validation croisée |

Les capteurs à fibre optique représentent une troisième voie prometteuse. Avec des temps de réponse de 10 à 50 millisecondes et une précision de ±0.2°C, ils combinent les avantages des deux technologies traditionnelles. Leur immunité totale aux interférences électromagnétiques et leur capacité à multiplexer des centaines de points de mesure sur une seule fibre en font des candidats idéaux pour les zones à forte radiation, où les technologies électroniques classiques se dégradent rapidement. Leur adoption progressive dans les réacteurs de recherche préfigure leur déploiement dans les installations de production.

Détection des anomalies faibles : identifier la dérive avant qu’elle ne devienne critique

Même équipés de capteurs rapides et précis, les systèmes de surveillance modernes ne se contentent plus de déclencher des alarmes à seuil fixe. La vraie performance réside dans l’exploitation intelligente des données pour anticiper plutôt que réagir. Cette évolution transforme la mesure thermique d’une fonction passive de surveillance en outil prédictif capable d’identifier les anomalies faibles avant qu’elles ne compromettent la sûreté.

La surveillance des tendances supplante progressivement les alarmes à seuil dans la détection des dérives lentes. Un capteur peut indiquer une température de 318°C, bien en dessous du seuil d’alarme de 330°C, tout en révélant une dérive préoccupante. Si cette température était de 315°C la semaine précédente et de 312°C le mois dernier, la tendance haussière de 3°C par mois signale une anomalie potentielle, même si aucun seuil n’est franchi. Les systèmes modernes tracent ces évolutions et alertent les opérateurs sur des changements graduels invisibles aux alarmes classiques.

Un retour d’expérience de Fessenheim en 2017 illustre cette problématique. Un décalage de mesure sur les capteurs de la voie A avait été identifié mais non traité pendant 3 mois, comme le rapporte un document de sûreté. L’anomalie n’était visible que par comparaison avec la voie B, démontrant l’importance de l’analyse croisée des données pour détecter les dérives lentes qui échappent aux seuils absolus.

Les corrélations multi-paramètres renforcent la détection en analysant simultanément température, pression et débit pour identifier des signatures d’anomalies. Dans un fonctionnement normal, ces trois grandeurs évoluent selon des relations physiques prévisibles. Une augmentation de température s’accompagne d’une hausse de pression et d’une variation de débit caractéristiques. Si la température augmente sans variation de pression correspondante, cela peut signaler une défaillance instrumentale plutôt qu’une vraie anomalie thermique. Cette validation croisée élimine les fausses alarmes et renforce la confiance dans les mesures.

Les algorithmes de détection d’écarts statistiques identifient les comportements hors-norme par rapport aux modèles de référence. En phase d’exploitation stable, chaque paramètre thermique suit une distribution statistique connue avec une moyenne et un écart-type caractéristiques. Lorsqu’une mesure s’éloigne de plus de trois écarts-types de sa valeur habituelle, même sans franchir de seuil absolu, le système signale une anomalie potentielle. Cette approche probabiliste détecte des dérives subtiles qui passeraient inaperçues avec des seuils fixes.

Le diagnostic de défaillance des capteurs eux-mêmes constitue un enjeu critique : distinguer une vraie anomalie thermique d’une dérive instrumentale. Les techniques de validation incluent la comparaison entre capteurs redondants, l’analyse de cohérence physique (une température ne peut pas varier de 50°C en 1 seconde dans un circuit massif), et les tests de plausibilité (une température mesurée ne peut pas dépasser la température de saturation à la pression donnée). Ces algorithmes détectent automatiquement les capteurs défaillants et les excluent des calculs de sûreté, garantissant que les décisions opérationnelles reposent sur des mesures fiables.

À retenir

- Les cascades thermiques propagent les effets d’une variation localisée à travers l’ensemble des circuits en quelques minutes

- La redondance diversifiée garantit 99.95% de disponibilité en combinant thermocouples, RTD et fibres optiques

- L’arbitrage précision/rapidité adapte la technologie au régime opérationnel (transitoire ou stabilisé)

- La surveillance des tendances détecte les dérives lentes invisibles aux alarmes à seuil fixe

- Les innovations (fibres Bragg, capteurs diamant, IA prédictive) préparent les réacteurs de génération IV

Évolution technologique et enjeux futurs des mesures thermiques nucléaires

Les méthodes de détection d’anomalies que nous venons d’explorer ouvrent la voie à des approches prédictives et d’intelligence artificielle qui transforment le rôle même de la mesure thermique. Loin d’être un acquis figé, ce domaine connaît des innovations majeures face aux défis des réacteurs de génération IV, du vieillissement des parcs existants et de la numérisation des systèmes de contrôle-commande.

Les capteurs distribués à fibre optique révolutionnent le concept même de mesure ponctuelle. Contrairement aux thermocouples qui mesurent la température en un seul point, les fibres optiques à réseaux de Bragg permettent une mesure continue sur toute leur longueur. Une seule fibre de 100 mètres peut comporter 100 points de mesure espacés d’un mètre, offrant une cartographie thermique complète impossible à obtenir avec des capteurs conventionnels. Cette densité de mesure détecte des anomalies localisées qui échapperaient à un réseau de capteurs ponctuels espacés.

Projet FIBRA-W pour tokamak WEST : quand la fibre optique affronte le plasma

Le CEA a réalisé une première mondiale en intégrant des fibres optiques à réseaux de Bragg dans les composants face au plasma du tokamak WEST. Ces capteurs résistent à des températures extrêmes supérieures à 800°C et à des flux de chaleur de plusieurs MW/m², conditions inaccessibles aux technologies conventionnelles. Le multiplexage de mesures sur une seule fibre réduit drastiquement la complexité du câblage, préfigurant les technologies qui équiperont ITER et les futurs réacteurs de fusion.

L’intégration de l’intelligence artificielle pour la maintenance prédictive anticipe les défaillances de capteurs avant qu’elles ne surviennent. Les algorithmes d’apprentissage automatique analysent l’historique de milliers de capteurs pour identifier les signatures précurseurs d’une panne : augmentation du bruit de mesure, dérive progressive de la calibration, variations erratiques. En détectant ces signaux faibles, le système programme les remplacements préventifs pendant les arrêts planifiés plutôt que de subir des défaillances imprévues en cours d’exploitation. Cette approche réduit les coûts de maintenance tout en améliorant la disponibilité.

Les défis spécifiques aux SMR (Small Modular Reactors) et réacteurs de génération IV imposent de nouvelles contraintes. Ces technologies utilisent des fluides caloporteurs innovants comme le sodium liquide (550°C), les sels fondus (700°C) ou l’hélium sous pression (850°C), bien au-delà des 323°C des réacteurs à eau. Les capteurs conventionnels atteignent leurs limites dans ces environnements extrêmes. Le développement de nouveaux matériaux devient critique : 478 000€ investis en 2025 pour développer des capteurs diamant capables de fonctionner au-delà de 2000°C pour les réacteurs de fusion.

| Technologie | Température max | Densité mesures | Résistance radiation |

|---|---|---|---|

| Thermocouples classiques | 1350°C | 1 point/capteur | Moyenne |

| Fibres optiques Bragg | 800°C | 100 points/fibre | Excellente |

| Capteurs diamant (futur) | 2000°C+ | 1 point/capteur | Exceptionnelle |

Les capteurs sur les réseaux de Bragg sont potentiellement très intéressants dans les installations de fusion magnétique car ils sont insensibles aux interférences électromagnétiques

– CEA-IRFM, Rapport intégration fibres optiques tokamak

La cyber-sécurité des chaînes de mesure numériques émerge comme un enjeu stratégique. La digitalisation des systèmes de contrôle-commande connecte les capteurs à des réseaux informatiques, créant des vulnérabilités potentielles. Protéger l’intégrité des données thermiques contre les manipulations devient aussi critique que garantir la fiabilité physique des capteurs. Les architectures de sécurité intègrent désormais le chiffrement des signaux, l’authentification des capteurs et la détection d’intrusions pour garantir qu’une cyberattaque ne puisse pas fausser les mesures critiques ou déclencher des actions de sûreté intempestives.

Ces évolutions convergent vers une vision où la mesure thermique dépasse sa fonction traditionnelle de surveillance pour devenir un système intelligent, prédictif et auto-diagnostiquant. Les innovations actuelles ne remplacent pas les principes de redondance et de diversification, mais les enrichissent avec des capacités analytiques inédites. Pour approfondir ces concepts dans leur contexte global, vous pouvez comprendre l’énergie nucléaire et ses enjeux technologiques futurs.

Questions fréquentes sur les capteurs nucléaires

Pourquoi ne pas utiliser uniquement les capteurs les plus précis ?

Les capteurs très précis comme les RTD platine ont des constantes de temps thermiques élevées (jusqu’à 10 secondes), inadaptées pour détecter des transitoires rapides critiques pour la sûreté. En situation d’urgence, la rapidité de détection prime sur la précision absolue.

Comment arbitrer entre précision et rapidité ?

L’arbitrage dépend du régime de fonctionnement : en régime stabilisé, la précision prime pour optimiser le rendement; en régime transitoire, la rapidité est essentielle pour la sûreté. Les installations utilisent donc simultanément plusieurs technologies adaptées à chaque zone.

Qu’est-ce qu’un pcm en réactivité nucléaire ?

Le pcm (pour cent mille) mesure l’écart à la criticité du réacteur. Une variation de 30 pcm signifie une modification de 0,03% de la réactivité neutronique, suffisante pour influencer significativement la puissance du cœur et nécessiter des ajustements de pilotage.

Comment fonctionne la logique de vote 2/3 ?

Dans une configuration 2/3, trois capteurs mesurent le même paramètre. Le système déclenche une action de sûreté seulement si au moins deux capteurs sur trois franchissent simultanément le seuil d’alarme. Cette logique évite les fausses alarmes dues à une défaillance isolée tout en garantissant la détection d’une anomalie réelle.